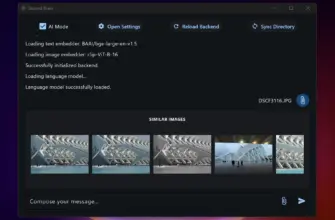

Твой персональный ChatGPT (Self-hosting), который работает 100% оффлайн.

Jan AI — это Open Source платформа, превращающая ваш компьютер в локальный сервер искусственного интеллекта. Главная особенность — полная совместимость с OpenAI API, что позволяет использовать локальные модели в любых приложениях, которые раньше требовали платных ключей от ChatGPT. В отличие от облачных сервисов, Jan хранит все данные и процессы на вашем устройстве.

Почему стоит выбрать Jan AI

- Полная приватность: Ваши промпты и данные никогда не покидают ваш компьютер.

- Гибкость моделей: В один клик устанавливайте Llama 3, Mistral, Gemma или подключайтесь к удаленным API (OpenAI, Claude).

- OpenAI-совместимость: Встроенный локальный сервер позволяет использовать Jan как замену платному API в других приложениях.

- Open Source: Она бесплатная и прозрачная.

Технические требования: Работает на Windows, macOS (включая процессоры M1/M2/M3) и Linux. Для стабильной работы локальных моделей (инференса) критически важны ресурсы вашего железа:

| Компонент | Минимальные требования | Рекомендовано (для моделей 13B+) |

| CPU | 4 ядра (с поддержкой AVX2) | 8+ ядер |

| RAM | 8 GB | 32 GB и выше |

| GPU | Не обязательно | NVIDIA (8GB+ VRAM) / Apple M-series |

| Диск | 20 GB (SSD) | 100 GB+ (под библиотеку моделей) |

Ключевые сценарии использования

- Локальный RAG (Base Knowledge): Интеграция с вашими PDF, документами и базами данных через векторные индексы (Chroma/FAISS).

- Разработка и тесты: Использование локального эндпоинта

http://localhost:1337для отладки кода без затрат на API облачных провайдеров. - Приватный ассистент: Настройка персональных ролей (Кодер, Аналитик, Редактор) с сохранением истории переписки на диске.

Нужен ли интернет для работы Jan?

Только для загрузки моделей. После этого вы можете общаться с ИИ в полностью автономном режиме.

Платная ли это программа?

Нет, Jan полностью бесплатна и распространяется под лицензией Apache 2.0.

Можно ли использовать Jan AI как замену платному API OpenAI?

Да. Jan запускает локальный сервер, который полностью имитирует структуру запросов OpenAI. Вы можете просто изменить base_url в своем приложении на локальный, и оно начнет работать с моделями Llama, Mistral или Gemma.

Какие форматы моделей поддерживает Jan?

Jan работает с большинством современных форматов, включая GGUF (оптимально для CPU), TensorRT и другие квантованные версии, которые значительно ускоряют работу на домашнем железе.

Нужно ли устанавливать дополнительные драйверы?

Для Windows/Linux пользователей рекомендуется установка драйверов NVIDIA CUDA или библиотек ROCm (для AMD), чтобы задействовать видеокарту. На macOS (процессоры M1/M2/M3) всё работает «из коробки» благодаря поддержке Metal.