Хостинг AlexHost — это профессиональная инфраструктурная платформа, предоставляющая выделенные мощности для реализации самых ресурсозатратных задач в сфере искусственного интеллекта. Провайдер берет на себя роль технического фундамента, предлагая специализированные серверы с графическими картами NVIDIA и NVIDIA Tesla, которые необходимы для обучения нейросетей (Deep Learning), работы с большими языковыми моделями (LLM) и машинного обучения. Использование такого решения избавляет от необходимости закупать дорогостоящее оборудование и решать вопросы его охлаждения или обслуживания, что критически экономит бюджет на старте любого ИИ-проекта. По сравнению с локальным запуском моделей на пользовательских ПК, серверы AlexHost обеспечивают бесперебойную работу в режиме 24/7 и позволяют масштабировать вычислительную мощность по мере роста сложности ваших алгоритмов или объема обрабатываемых данных.

Процесс взаимодействия с платформой ориентирован на максимальную прозрачность и высокую скорость развертывания: после выбора конфигурации в личном кабинете пользователь получает полный контроль над выделенным сервером с гарантированными ресурсами. При заказе услуг для задач ИИ интерфейс и поддержка помогают быстро сориентироваться в выборе нужной ОС и версии драйверов, что делает вход в разработку комфортным даже для тех, кто только начинает свой путь в Data Science. Качество сетевого соединения и высокая пропускная способность каналов гарантируют, что запросы к вашим развернутым моделям будут обрабатываться без задержек, а наличие полноценной русскоязычной локализации и поддержки значительно упрощает ежедневную эксплуатацию инфраструктуры.

Вердикт

Вердикт для профессионального сообщества однозначен: AlexHost является оптимальным звеном в цепочке разработки ИИ-сервисов, обеспечивая идеальный баланс между производительностью и стоимостью аренды GPU. Учитывая лояльность сервиса к конфиденциальности и возможность оплаты криптовалютой, его стоит добавить в закладки как надежный хаб для развертывания анонимной и мощной инфраструктуры, которая не подведет в моменты пиковых нагрузок.

Подходит для: разработчиков нейросетей, Data Scientist, специалистов по Deep Learning, владельцев PBN-сетей, ИИ-стартапов, DevOps-инженеров.

Выбор подходящего тарифа для GPU-выделенных серверов

Выделенные серверы предоставляются с двумя мощными и современными видеокартами 2x RTX 4070 Ti SUPER. Еще одним важным элементом является то, что AlexHost предоставляет полный набор предустановленных инструментов и фреймворков, специально разработанных для упрощения развертывания и использования больших языковых моделей (LLM), что позволит вам сразу же начать работать с AI-решениями. Это поможет вам сразу же получить сервер с развертываемым инструментом ИИ.

- Пользовательский интерфейс Oobabooga Text Gen

- PyTorch (CUDA 12.4 + cuDNN)

- SD Webui A1111

- Ubuntu 22.04 VM: GNOME Desktop + RDPXFCE Desktop + RDPKDE Plasma Desktop + RDP

- Также: По желанию заказчика можно установить любую ОС

Установка моделей LLM

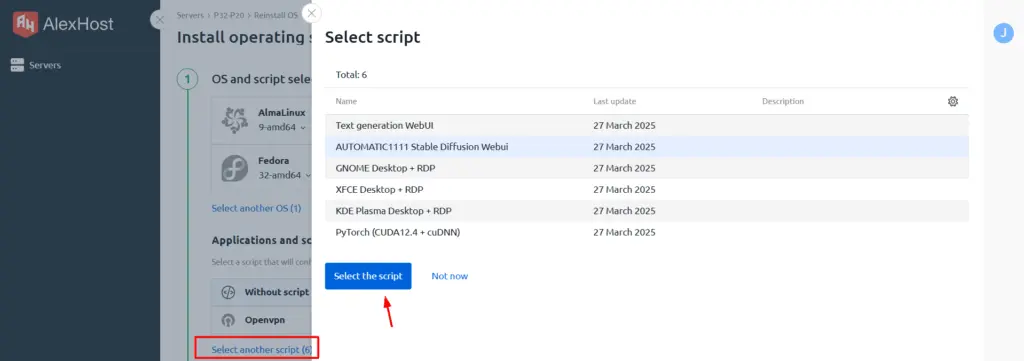

Выбрав опцию Select another scripts, вы получите доступ к установке всех доступных моделей LLM. Давайте вкратце рассмотрим каждую из них:

- Генерация текста WebUI – это веб-интерфейс для работы с моделями генерации текста, такими как GPT, LLaMA, Mistral и другими. Он позволяет загружать модели, настраивать параметры и взаимодействовать с текстовыми LLM.

- AUTOMATIC1111 Stable Diffusion WebUI – один из самых популярных веб-интерфейсов для генерации изображений с помощью модели Stable Diffusion. Он предоставляет удобный графический интерфейс, в котором можно загружать модели, настраивать параметры генерации изображений, использовать дополнительные плагины и расширения.

- GNOME / XFCE / KDE Plasma Desktop + RDP – это различные графические среды для удаленного подключения к серверу по протоколу RDP (Remote Desktop Protocol). Они не имеют прямого отношения к LLM, но могут быть использованы для управления и работы с сервером, на котором запущены модели ИИ.

- PyTorch (CUDA12.4 + cuDNN) – библиотека для работы с нейронными сетями и машинным обучением. Она поддерживает GPU-ускорение (через CUDA) и используется для обучения и запуска LLM (например, GPT, LLaMA) и моделей генерации изображений (Stable Diffusion).

Обратите внимание, что процесс установки может занять до 30 минут.