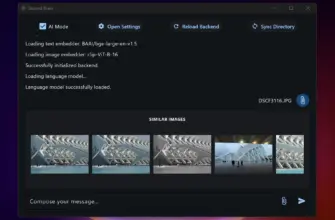

Я давно экспериментирую с локальными моделями и недавно попробовал Jan AI. Мне понравилась идея: запускать мощный ИИ прямо на своём компьютере без интернета. Это даёт контроль над данными и свободу в настройке. Дальше расскажу, что это такое и зачем вообще может пригодиться.

- Jan AI: что это и зачем использовать локальный ИИ без интернета

- Преимущества и ограничения jan ai при работе без интернета

- Как пользоваться jan ai офлайн: первый запуск и базовые сценарии

- Системные требования и подготовка оборудования

- Пошаговая установка и запуск (Linux, macOS, Windows, Docker)

- Linux (Ubuntu)

- macOS

- Windows (WSL2 предпочтительнее)

- Docker

- Как пользоваться: работа с OpenAI-совместимым локальным API

- Выбор, загрузка и управление моделями для jan ai

- Квантование, оптимизация и ускорение инференса

- Обновление, замена и резервное копирование моделей

- Настройка персональных ассистентов и промпт-дизайн (как пользоваться для задач)

- Создание цепочек промптов и инструментов (tooling)

- Интеграции и автоматизация: примеры использования jan ai без интернета

- Интеграция с локальными базами знаний и векторными индексами

- Автоматизация рабочих процессов: скрипты, cron, вебхуки и триггеры

- Безопасность, управление доступом и конфиденциальность данных

- Шифрование, секреты и безопасное хранение данных локально

- Тестирование, отладка и типичные проблемы при офлайн-работе

- Частые ошибки при установке и их решения

- Сообщество, обновления и ресурсы для развития навыков с jan ai

- Полезные инструменты, шаблоны и репозитории

- Реальные кейсы и готовые сценарии использования jan ai без интернета

- Заключение: как принять решение о переходе на jan ai офлайн

Jan AI: что это и зачем использовать локальный ИИ без интернета

Для меня jan ai — это инструмент, который превращает локальную машину в небольшую AI-платформу. Он обычно предоставляет совместимый с OpenAI API интерфейс. Это значит, что многие приложения и скрипты, которые привыкли работать с облаком, можно перенаправить на локальный сервер без больших переделок. Я вижу в этом смысл, когда не хочется отправлять конфиденциальные данные в облако. Ещё это полезно в местах со слабым интернетом или когда нужен детерминированный ответ без внешних обновлений модели.

Зачем использовать локально? Я перечислю основные причины, которые лично для меня сыграли роль:

- Конфиденциальность: данные остаются у меня.

- Предсказуемость: поведение модели стабильно, пока я не обновлю её.

- Интеграция с локальными данными: быстро искать по собственным архивам и базам.

- Экономия на облачных запросах при частом использовании.

При этом jan ai часто служит мостом между моделями, которые вы загрузите, и приложениями, которые их используют. Это удобно, когда хочется быстро прототипировать ассистента или автоматизацию, не привязываясь к внешним провайдерам.

Преимущества и ограничения jan ai при работе без интернета

Я сразу говорю про плюсы и минусы, потому что важно понимать компромиссы. Локальный ai даёт свободу, но требует ресурсов и заботы о безопасности.

| Преимущества | Ограничения |

|---|---|

| Полный контроль над данными и конфигурацией | Нужны CPU/GPU и достаточно места для моделей |

| Нет зависимости от внешнего интернета | Нет автоматических обновлений знаний модели |

| Возможность кастомизации и интеграции с локальными системами | Требуется администрирование и резервное копирование |

Мне помогла такая привычка: сначала оценить задачи и только потом переносить их офлайн. Если задача — генерация текста и работа с локальной базой, локальный режим идеален. Если нужна самая свежая мировая информация, облачные сервисы всё ещё выигрывают.

Совет: если важна актуальность знаний, комбинируйте локальную модель с периодическим обновлением данных из безопасных источников.

Ещё отмечу технические ограничения. Для больших моделей нужна хорошая видеокарта и много RAM. На слабых машинах придётся использовать меньшие или квантованные версии модели. В других случаях вы столкнётесь с задержками при инференсе и возможными несовместимостями со старыми приложениями.

Как пользоваться jan ai офлайн: первый запуск и базовые сценарии

Я обычно начинаю с подготовки. Если вы задумались, как пользоваться jan ai, то порядок такой: подготовить систему, загрузить модель, запустить сервер и подключиться через API. Всё просто, если разбить на шаги.

- Проверяю системные требования и освобождаю место под модель.

- Скачиваю нужную модель и разворачиваю её в отдельную папку.

- Запускаю jan ai-сервер и проверяю health endpoint.

- Подключаюсь через curl или уже знакомую библиотеку, меняю endpoit на локальный.

Типовые сценарии, которые я использую:

| Сценарий | Пример |

|---|---|

| Генерация текстов | curl к локальному /v1/chat/completions |

| Локальный ассистент | Интеграция с GUI или CLI, чтение локальных файлов |

| Поиск по базе знаний | Векторные индексы и запросы к модели для ранжирования |

Прямой лайфхак: для быстрого теста используйте уменьшенную модель. Так вы проверите интеграцию без долгого ожидания и большого расхода ресурсов.

В общем, как пользоваться — решать вам. Я предпочитаю начать с простых задач. Потом добавляю автоматизацию и интеграции. Такой подход экономит время и нервные клетки.

Системные требования и подготовка оборудования

Я всегда начинаю с проверки железа. jan — локальный ИИ. Он любит быстрые диски и много оперативки. Для базовых моделей подойдёт обычный ноутбук. Для серьёзной работы с большими моделями нужен GPU. Ниже я расписал ориентиры, чтобы тебе было проще сориентироваться.

| Компонент | Минимум | Рекомендовано |

|---|---|---|

| CPU | 4 ядра | 6+ ядер, современные инструкции (AVX/AVX2) |

| RAM | 8 GB | 32+ GB |

| GPU (если нужен) | не обязательно | NVIDIA 8GB+ или эквивалент с поддержкой CUDA/ROCm |

| Диск | 20 GB свободного | SSD, 100+ GB (модели и кеш) |

| ОС | Linux/macOS/Windows 10+ | Linux (Ubuntu) для максимальной гибкости |

Перед установкой проверь драйверы GPU. На Linux это NVIDIA драйверы и CUDA или ROCm для AMD. На macOS убедись, что Homebrew установлен. На Windows полезны WSL2 и драйверы CUDA. Я также рекомендую выделить отдельный диск или раздел для моделей. Они занимают место быстро.

Совет: обнови систему и установи Python 3.10+. Это экономит время при установке зависимостей.

Пошаговая установка и запуск (Linux, macOS, Windows, Docker)

Я опишу простую последовательность для каждой платформы. Следуй шагам и проверяй вывод команд. Если где-то остановилось — вернись к предыдущему шагу.

Linux (Ubuntu)

- Обнови систему:

sudo apt update && sudo apt upgrade -y

- Установи зависимости:

sudo apt install -y python3 python3-venv python3-pip git build-essential

- Настрой драйверы GPU (при наличии NVIDIA):

sudo apt install -y nvidia-driver-### cuda-toolkit-###

- Клонируй jan и создай виртуальное окружение:

git clone https://github.com/.../jan.git

cd jan

python3 -m venv venv

source venv/bin/activate

pip install -r requirements.txt - Запусти локальный сервер:

python run_server.py --port 8080

macOS

- Установи Homebrew, если нет:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

- Установи Python и Git:

brew install python git

- Дальше как на Linux: клонируй проект, создай venv и установи зависимости.

- На Apple Silicon проверь совместимость моделей и используемые бинарники.

Windows (WSL2 предпочтительнее)

- Включи WSL2 и установи Ubuntu из Microsoft Store.

- Следуй инструкциям для Linux внутри WSL.

- Если запускаешь нативно в Windows, установи Python и Git, затем выполняй те же шаги в CMD/PowerShell.

Docker

Docker удобен для изоляции и быстрого развёртывания. Я обычно так делаю:

- Установи Docker и Docker Compose.

- Создай файл docker-compose.yml или используй готовый из репозитория jan.

- Запусти:

docker-compose up -d --build

- Проверь логи:

docker-compose logs -f

Docker полезен, если хочешь одинаковую среду на разных машинах. Минус — нужны ресурсы и настройки GPU passthrough.

Как пользоваться: работа с OpenAI-совместимым локальным API

Я говорю простыми словами. jan предоставляет API, похожее на OpenAI. Это удобно. Сохраняешь привычные скрипты. Меняются только адрес и ключи.

Типичный базовый запрос curl выглядит так:

curl http://localhost:8080/v1/chat/completions \

-H "Authorization: Bearer local-secret" \

-H "Content-Type: application/json" \

-d '{"model":"gpt-j","messages":[{"role":"user","content":"Привет, как дела?"}]}'

В Python всё ещё проще:

import requests

resp = requests.post(

"http://localhost:8080/v1/chat/completions",

headers={"Authorization":"Bearer local-secret"},

json={"model":"gpt-j","messages":[{"role":"user","content":"Привет"}]}

)

print(resp.json())

Советы по использованию:

- Храни ключ в переменной окружения: JAN_API_KEY. Не пиши его в коде.

- Проверяй доступность: GET /v1/models вернёт список доступных моделей.

- Для стриминга используй SSE или WebSocket, если jan это поддерживает.

- Ограничь одновременные запросы. Локальная машина легко перегружается.

Пример: установи в коде таймауты и повторные попытки. Это спасёт от подвисаний при длинном инференсе.

Для интеграции с существующим кодом достаточно сменить URL и ключ. Остальные части запроса остаются совместимыми с OpenAI. Я всегда тестирую сначала простым запросом, затем добавляю промпты и логику.

Выбор, загрузка и управление моделями для jan ai

Я подхожу к выбору модели прагматично. Сначала решаю, что мне важнее: скорость или качество. Малые модели работают быстро и не требуют много памяти. Большие дают точнее ответы, но медленнее и занимают место. Я смотрю на формат модели: ggml, FP16, GPTQ — от этого зависит, как её запустить локально. Скачиваю только из проверенных источников: официальные репозитории, Hugging Face или проверенные форки. Всегда проверяю размер и контрольную сумму файла перед установкой.

| Тип модели | Плюсы | Минусы |

|---|---|---|

| Малые (LLaMA-7B и подобные) | Быстро, мало ресурсов | Меньше точности |

| Средние (13B—30B) | Баланс скорости и качества | Требуют больше памяти |

| Крупные (70B+) | Лучшее качество | Нужны GPU/много RAM |

Перед загрузкой проверяю свободное место и пропускную способность диска. Я всегда храню метаданные рядом с моделью: версию, источник и дату скачивания. Это помогает управлять несколькими моделями и быстро переключаться между ними.

Совет: называйте файлы моделей по шаблону вида model-name_version_quant.bin. Так легче автоматизировать обновления и откат.

Квантование, оптимизация и ускорение инференса

Квантование сокращает размер модели и ускоряет инференс. Я чаще использую 4-bit и 8-bit квантование в зависимости от задачи. 8-bit даёт хороший баланс скорости и качества. 4-bit сильнее уменьшает память, но иногда портит точность. Для квантования применяю инструменты вроде GPTQ или библиотеки, встроенные в экосистему jan ai/llama.cpp.

| Квантование | Память | Качество |

|---|---|---|

| FP16 | Средняя | Высокое |

| 8-bit | Низкая | Хорошее |

| 4-bit | Очень низкая | Среднее |

Оптимизации, которые я применяю: включаю многопоточность, подбираю число потоков по ядрам CPU, использую mmap для загрузки моделей и отключаю ненужные логгеры. На CPU смотрю наличие инструкций AVX/AVX2/AVX512 — это ускоряет матричные операции. На GPU важно выбрать совместимый драйвер и CUDA-совместимую сборку. Тестирую скорость с разными параметрами batch и context size, чтобы найти лучший компромисс.

Обновление, замена и резервное копирование моделей

Я обновляю модели осторожно. Никогда не перезаписываю рабочую модель в продакшене. Создаю отдельную папку для новой версии и прогоняю тесты локально. Сравниваю контрольные суммы и результаты на контрольных промптах. Если всё ок, делаю переключение через символическую ссылку или перемещение в место, где ожидает jan ai. Основные шаги, которые я выполняю: — Сохраняю текущую модель в архив с датой. — Загружаю новую модель в тестовую папку. — Прогоняю быстрый тест по набору промптов. — Если результаты допустимы, меняю ссылку на модель. Я храню резервные копии как локально, так и вне машины — на NAS или в облачном хранилище. Настраиваю автоматические бэкапы раз в неделю и проверяю целостность архива. Для критичных систем использую версионирование и журнал изменений, чтобы можно было быстро откатиться к предыдущей версии.

Настройка персональных ассистентов и промпт-дизайн (как пользоваться для задач)

Я люблю делать персональных ассистентов под конкретные задачи. Сначала задаю системное сообщение: роль, тон и ограничения. Затем добавляю шаблоны промптов для повторяющихся задач. Так получается стабильное поведение. Я часто создаю несколько профилей: «резюме», «кодер», «помощник по письмам». Переключаю профиль в зависимости от задачи. Список ключевых принципов, которые я использую: — Чётко указываю роль и формат ответа. — Делю задачу на шаги и даю пример ожидаемого результата. — Ограничиваю длину и стиль, если нужно. — Пробую разные температуры и max_tokens для баланса креативности и точности. Пример простого шаблона промпта:

Роль: эксперт по документации. Задача: сократить текст до 30% без потери смысла. Выход: пунктовый список, 5—7 пунктов.

Для сложных сценариев я строю цепочки промптов. Первый промпт анализирует данные. Второй генерирует черновик. Третий делает проверку качества. В jan ai это настраивается как последовательность запросов к локальному API. Так я добиваюсь надёжности и предсказуемости. Для автоматизации часто сохраняю шаблоны в YAML или JSON, чтобы можно было быстро подставлять переменные и запускать из скрипта.

Создание цепочек промптов и инструментов (tooling)

Я обычно строю цепочки промптов как набор маленьких шагов. Каждый шаг решает простую задачу. Потом я соединяю их в последовательность. Это проще отлаживать. Это проще улучшать.

Типичная цепочка выглядит так: получение контекста, поиск по базе знаний, генерация черновика, проверка фактов, форматирование выхода. Я использую минимальные промпты для каждого шага. Так модель не теряет фокус. Если что-то идет не так, я меняю только один шаг.

Вот основные паттерны, которые я применяю:

- Ретривер + генератор: сначала похожие документы, потом RAG-генерация.

- Разделение ролей: один промпт выступает как «эксперт», другой как «редактор».

- Контроль качества: отдельный промпт для проверки фактов и стиля.

- Функциональные вызовы: промпты вызывают локальные утилиты (чтение файла, поиск по векторному индексу).

Инструменты (tooling) я группирую в таблицу. Так видно, что за что отвечает.

| Инструмент | Назначение | Почему локально |

|---|---|---|

| Ретривер (FAISS/Chroma) | Поиск релевантных отрывков | Быстрая выдача, приватность |

| Промпт-шаблонизатор | Управляет переменными в промпте | Упрощает тестирование |

| Проверщик фактов | Сверяет вывод с локальной БД | Избежание выдумок |

| Файловые адаптеры | Читают локальные документы | Работа без интернета |

Совет: держите промпты короткими и документируйте входы/выходы каждого шага. Это сильно экономит время при отладке.

Я всегда тестирую цепочку на простых сценариях. Потом усложняю. Много проблем уходит на ранних тестах. Для повторяемости я сохраняю промпты и версии моделей. Так можно откатиться, если результат ухудшился.

Интеграции и автоматизация: примеры использования jan ai без интернета

Я подключаю jan ai к локальным сервисам. Так создаю полезные автоматизации. Примеры простые, понятные и реальные. Они работают в офлайне и защищают данные.

Вот общие сценарии:

- Помощник по документации, который отвечает на вопросы команды, читая внутренние файлы.

- Автоматическое создание отчётов из логов и CSV.

- Интеграция с локальной CRM для подготовки шаблонов писем.

- Автономные аналитические пайплайны: извлечение, суммаризация, оповещение.

Интеграция с локальными базами знаний и векторными индексами

Я храню знания локально. Чаще всего это набор документов, PDF и база данных. Сначала я разбиваю документы на куски. Потом генерирую эмбеддинги с локальной моделью. Эти эмбеддинги сохраняю в векторном индексе.

Использую FAISS или Chroma. Оба работают офлайн. FAISS хорош для скорости. Chroma проще интегрировать. Для больших проектов беру Milvus или локальный Weaviate.

Процесс обычно такой:

- Загрузка документов и их нормализация.

- Чанкинг: разбиение на логичные отрывки.

- Генерация эмбеддингов локально.

- Индексирование в FAISS/Chroma.

- При запросе — поиск похожих отрывков и добавление в промпт.

Ниже краткая таблица с плюсами и минусами индексов.

| Индекс | Плюсы | Минусы |

|---|---|---|

| FAISS | Очень быстро, компактный | Меньше удобств для метаданных |

| Chroma | Простой API, хранилище метаданных | Может быть медленнее на больших объёмах |

| Milvus/Weaviate | Масштабируемость, интерфейсы | Сложнее в настройке локально |

Важно: эмбеддинги генерировать той же моделью, которую вы используете для поиска, иначе сходство будет плохим.

Автоматизация рабочих процессов: скрипты, cron, вебхуки и триггеры

Я автоматизирую рутинные задачи простыми скриптами. Чаще всего это Python или Bash. Скрипты вызывают локальный API jan ai. Дальше данные обрабатываются и сохраняются.

Способы триггеров:

- cron/systemd timers — для регулярных задач: отчёты, бэкапы, индексация.

- inotify/file watchers — реагируют на появление новых файлов.

- локальные вебхуки — сервисы в LAN могут отправлять уведомления на jan ai.

- скриптовые цепочки — один скрипт запускает другой по результату.

Пример сценария: скрипт сканирует папку с логами раз в час, извлекает ключевые события, отправляет их в jan ai для суммаризации, а затем кладёт результат в папку отчётов. Всё работает без интернета. Можно добавить отправку уведомления в мессенджер внутри локальной сети.

Ниже таблица триггеров и типичных задач.

| Триггер | Задача |

|---|---|

| cron | Ежедневные сводки, индексация новых документов |

| inotify | Обработка загруженных файлов, автоматическая генерация метаданных |

| локальный webhook | Реакция на действия в других системах LAN |

| systemd | Долгоживущие демоны и наблюдатели |

Часто проверяю логи и держу простую систему оповещений. Это спасает от тихих сбоев и помогает вовремя реагировать.

Если нужно, могу прислать шаблоны скриптов и примеры конфигураций cron/systemd. Они у меня уже проверены в нескольких проектах.

Безопасность, управление доступом и конфиденциальность данных

Я считаю, что локальный ИИ — это не только автономность. Это еще шанс взять контроль над своими данными. Когда jan ai работает у вас в сети, я делаю ставку на несколько простых принципов. Первый — минимум прав для сервисов. Вторая — разделение сетей и сервисов. Третья — аудит и логирование событий.

Практически всегда я делю окружение на зоны. Модель и данные живут в изолированной подсети. Интерфейсы для пользователей — в другой. Админские панели — в третьей. Так я уменьшаю риски компрометации. Также я рекомендую настраивать ролевую модель доступа. Нужны роли: админ, оператор, пользователь. Каждой роли свои права.

| Направление | Что я делаю | Почему это важно |

|---|---|---|

| Сегментация сети | Изолирую модели от внешней сети | Меньше точек входа для атак |

| Управление доступом | RBAC и отдельные сервисные учётки | Минимизация прав = меньше рисков |

| Логирование и аудит | Храню логи отдельно и регулярно проверяю | Позволяет быстро обнаружить аномалии |

Ниже короткий список практик, которые я применяю немедленно при разворачивании jan ai:

- Отключаю ненужные сервисы и порты.

- Использую отдельные учётные записи для запуска сервисов.

- Включаю аудит доступа к моделям и к данным.

- Храню резервные копии отдельно и шифрую их.

Конфиденциальность — это не одно действие. Это набор мелких решений, которые вместе дают результат.

Шифрование, секреты и безопасное хранение данных локально

Шифрование — моя первая линия защиты для данных и ключей. Я всегда ставлю диск или том с моделями зашифрованным. Это помогает, если оборудование украдут или оно потеряется.

Для секретов я предпочитаю менеджер ключей. Можно использовать HashiCorp Vault, gpg или системные keyring. Никогда не храню ключи в коде. Если используется docker, я пробрасываю секреты через защищённые переменные или секреты оркестратора.

| Элемент | Рекомендация |

|---|---|

| Диски и тома | Полное шифрование (LUKS/BitLocker) |

| Секреты | Менеджер секретов (Vault / gnome-keyring / pass) |

| Передача данных | TLS даже внутри локальной сети |

Я также настраиваю ротацию ключей и регулярную проверку целостности. Храню резервные копии ключей в отдельном физическом хранилище. Если вы хотите простую опцию, шифруйте модельные файлы и храните ключ на USB в сейфе.

Тестирование, отладка и типичные проблемы при офлайн-работе

Тестирование офлайн-системы важно. Я проверяю не только работоспособность сервиса. Я прогоняю сценарии отказа. Симулирую потерю питания. Отключаю сеть. Это выявляет ошибки, которые обычное тестирование пропустит.

Важно разделять тесты на уровни. Юнит-тесты для утилит и загрузчиков. Интеграционные — для API и потоков данных. Нагрузочные — для оценки производительности. Мониторю метрики: задержки, использование памяти и CPU, ошибки инференса.

- Юнит-тесты: проверяю парсинг и обработку входных данных.

- Интеграционные: проверяю цепочку от запроса до ответа модели.

- Нагрузочные: имитирую пиковые сценарии и проверяю деградацию.

Я использую простые инструменты: curl для ручных проверок, wrk или locust для нагрузки, Prometheus + Grafana для мониторинга. Логи собираю централизованно. Это помогает быстро находить причинно-следственные связи.

Частые ошибки при установке и их решения

За годы установки jan ai я заметил ряд повторяющихся проблем. Я их записал и теперь решаю быстро.

| Проблема | Симптом | Решение |

|---|---|---|

| Нехватка памяти | Процессы падают при загрузке модели | Увеличить swap или использовать квантованную модель |

| Несовместимые драйверы GPU | Ошибки при инициализации CUDA | Проверить версии драйверов и библиотеки CUDA/CuDNN |

| Проблемы с правами файлов | Доступ отказан при чтении модели | Проверить владельца и права, использовать безопасные сервисные учётки |

| Порт занят | Сервис не запускается: адрес уже используется | Найти процесс и остановить или сменить порт в конфиге |

Еще несколько быстрых советов, которые я даю себе и коллегам:

- Проверяйте логи сразу. Они часто говорят, что именно сломалось.

- Запускайте сервис в интерактивном режиме при отладке.

- Делайте контрольные точки: если после обновления что-то сломалось, быстро откатиться.

Отладка — это разговор с системой. Слушайте ошибки, они подскажут путь к исправлению.

Сообщество, обновления и ресурсы для развития навыков с jan ai

Я сам регулярно захожу в сообщества вокруг jan ai. Там быстро узнаю о новых релизах, патчах и инструкциях. Важно быть в курсе, потому что локальные проекты часто развиваются через пулл-реквесты и сторонние утилиты. Я подписываюсь на рассылки, читаю дела в трекерах и участвую в обсуждениях. Так проще находить готовые решения и избегать типичных ошибок.

| Ресурс | Для чего | Частота обновлений |

|---|---|---|

| GitHub/репозитории | Код, релизы, issue | в моментах релизов |

| Discord/Slack/Matrix | Быстрые вопросы и советы | постоянно |

| Форумы и Reddit | Обсуждения сценариев и кейсов | регулярно |

| Документация и вики | Установка и примеры | по мере обновлений |

Советую сохранять закладки на несколько источников и включать уведомления о релизах. Я также держу локальную копию ключевой документации. Это помогает работать офлайн и быстро решать проблемы без интернета.

Полезные инструменты, шаблоны и репозитории

Я использую набор инструментов, который экономит время при настройке и эксплуатации jan ai. Некоторые вещи реально упрощают жизнь. Ниже перечислю те, что чаще всего применяю.

- Инструменты для запуска: докер-контейнеры, скрипты systemd, готовые образы.

- Конвертеры и рантаймы: llama.cpp, ggml-форматы, утилиты для преобразования из Hugging Face.

- Векторные хранилища: FAISS, Chroma, Milvus для локальных векторных индексов.

- CLI и локальные API-обертки, совместимые с OpenAI API, для единообразной интеграции.

- Шаблоны промптов и конфигураций для персональных ассистентов и чатов.

Ниже пример, как выглядит простая структура репозитория, которую я часто клонирую и адаптирую:

config/ run.sh docker-compose.yml models/ prompts/ docs/README.md

Если нужно ускорить инференс, я беру готовые скрипты квантования и тесты производительности. Репозитории с шаблонами обычно содержат инструкции для Linux, macOS и Windows. Однажды я настроил шаблон под cron‑задачи за час, и он работал стабильно без интернета.

Реальные кейсы и готовые сценарии использования jan ai без интернета

Я люблю реальные примеры, потому что они помогают понять, где локальный ИИ действительно полезен. Ниже мои любимые сценарии, которые уже проверены в работе и в хобби‑проектах.

- Персональный офлайн‑ассистент для заметок, планирования и поисковых запросов по локальным документам.

- Встраиваемая аналитика в производство для обработки журналов и предупреждений без отправки данных в облако.

- Медицинские протоколы и справочные системы в клинике, где важна конфиденциальность и доступ офлайн.

- Автономные квантификаторы и генерация отчетов на IoT‑устройствах с ограниченным соединением.

- Локальная генерация контента для сайтов и приложений, где требуется полный контроль над данными.

| Сценарий | Польза | Необходимая инфраструктура |

|---|---|---|

| Офлайн‑ассистент для документов | Конфиденциальность, быстрый поиск | Сервер 8+ GB RAM, векторный индекс |

| Производственный мониторинг | Надёжность, отсутствие облачной зависимости | Локальные агенты, скрипты автоматизации |

| Медицинская справка | Соответствие требованиям конфиденциальности | Ограждённая сеть, резервные копии |

Один из моих проектов — офлайн‑ассистент для инженеров. Он отвечал на вопросы по чертежам и документации прямо на заводе. Никаких внешних вызовов. Результат: ускорение поиска информации и меньше утечек данных.

Важно трезво оценивать ожидания. Локальные модели не всегда заменят облако по качеству генерации. Зато они дают контроль, безопасность и предсказуемую задержку.

Заключение: как принять решение о переходе на jan ai офлайн

Я подхожу к решению практично. Сначала задаю ключевые вопросы. Нужна ли мне полная конфиденциальность данных? Требуется ли работа без интернета? Какой бюджет на оборудование и поддержку? Ответы помогают выбрать стратегию.

- Определите требования: безопасность, доступность, производительность.

- Оцените ресурсы: есть ли серверы, навыки по администрированию, бюджет на модели.

- Сделайте прототип: простая задача, минимальный стек, тесты офлайн.

- Измерьте метрики: латентность, качество ответов, нагрузку на железо.

- Примите решение: полный офлайн, гибрид или продолжать в облаке.

Я всегда советую начинать с прототипа. Так вы увидите реальные плюсы и минусы. Сообщество и готовые репозитории помогут сократить время на внедрение. Если перед установкой вы хотите еще раз свериться с системными требованиями или посмотреть альтернативы, загляните в нашу карточку Jan AI в каталоге нейросетей — там мы собрали все технические характеристики в удобном формате.